Facebook最新データセンターの中身:クラウドHot Topics(3)(1/2 ページ)

フェイスブックが、同社の最新データセンターで採用しているサーバとデータセンター設備の仕様を公開した。このデータセンターは効率性と経済性が高く、PUEは1.07だという。公開された仕様書から、フェイスブックがどのような工夫をしているかを探ってみた。

米フェイスブックは2011年4月7日、同社が米オレゴン州プラインヴィル(Prineville)に建設したデータセンターにおける、設備やサーバの仕様を詳細に公開した。誰でも自由に利用できるようになっている。

フェイスブックは、4月中に運用を開始するプラインヴィルのデータセンターが、他の最先端データセンターに比べ、効率が38%高く、経済性も24%高いと発表している。この数値の具体的な根拠は必ずしも明らかではない。しかし、同データセンターのPUE(Power Usage Effectiveness:データセンター全体の消費電力をIT機器の消費電力で割った数値)が1.07というのは驚きの数値だ。これは、データセンターに供給される電力の約93.5%がサーバやイーサネットスイッチに使われることを意味する。いいかえれば、空調やその他のデータセンター維持のために使われる電力は、全体の約6.5%程度にしかすぎない(前述で「効率が38%高い」というのは、PUEが、最近のデータセンターの平均値として同社が指摘する1.5に対し、プラインヴィルは1.07であるところからきているのかもしれない)。

プラインヴィルは、フェイスブックにとって初の自社設計によるデータセンターという。同社は、サーバ機についてはAMD、インテルそれぞれのサーバCPUのための、カスタム設計のマザーボード、これらに共通なサーバ機のシャーシ、サーバの電源ユニット、カスタム設計のサーバキャビネット、バックアップバッテリユニット、データセンターの冷却システムについて、仕様を公開している。つまり、データセンターを構成するすべての要素が、カスタム設計といっても過言ではない。

ここでは、フェイスブックが公開した文書を基に、フェイスブックがどのようなサーバやデータセンター設備を使用しているのかを探る。

サーバ機の密度は「ほどほど」

フェイスブックはマザーボードを含め、さまざまな点でカスタマイズを加えたサーバ設計を採用している。「vanity-free server」(虚飾を排したサーバ)という表現をしているが、無駄と思われる要素は積極的に排除するというのが基本的な考え方のようだ。

CPUには、主要なサーバ用プロセッサを採用している。Open Compute Projectで公開されたマザーボードの仕様は、AMDのOpteron 6100(12コア/8コア)、あるいはインテルのXeon 5500/5600(2〜6コア)に対応したデュアルソケットのボードだ。フェイスブックは、新たなCPUの選択肢を模索していると報道されることもあるが、少なくともプラインヴィルのデータセンターで主に使われているのは、これらの最新サーバCPUのようだ。

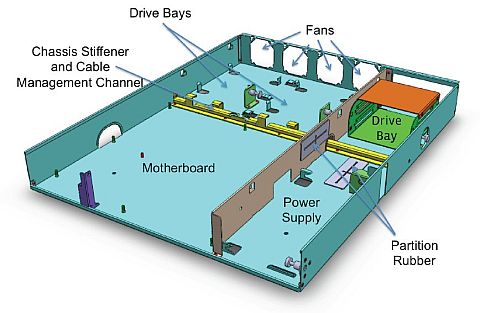

サーバのシャーシは幅480mmで、高さはおよそ1.5U(66mm)となっている。1Uより高くしたのは、背が高く表面積の広いヒートシンクをCPUにつけることで、CPU冷却効果を高めることが1つの理由という。これによってサーバの冷却のために送り込む冷気の温度を高めに設定できるようにし、エネルギーコストを下げるのが狙いのようだ。また、サーバ機の背面では60mm程度の大きめな冷却ファンを4個設置し、排気をより強力にしている。このファンは回転数が可変のもの。サーバ上の温度センサからの情報に基づき、1120 rpmから7600 rpmまでの間で、最適な回転数が設定される。

サーバ前面や上面のカバーはなし。事実上、マザーボードはむき出しの状態だ。これらがあるからといって、エネルギー効率は高まらないというのがその理由だ。ネジも排除している。拡張スロットはPCI-eスロットが1本だけだ。こうした「無駄」の徹底的な排除によって、サーバの重量も軽くなっているという。

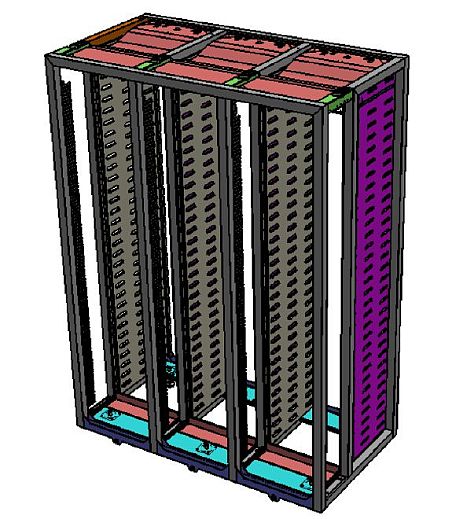

フェイスブックでは、このサーバを、ラックが3つ横につながったような特殊サイズのサーバキャビネットに収めている。1ラックに30サーバ、すなわち1サーバキャビネット当たり90サーバを搭載する設計という(ほかに1サーバキャビネット当たり2台のイーサネットスイッチが搭載される)。この数字だけ見れば、一般的な1Uのラックマウントサーバを使った場合のほうが、サーバ密度の点では有利といえる。ちなみにこのカスタムキャビネットのサイズは、幅1713mm、奥行き914.4mm、高さ2410.27mm。これは19インチラックを横に3つ並べたものよりも幅が広く、高さもかなり高い。

サーバ密度を積極的に上げることをしていないのは、外気を最大限に活用することにより、電力消費を抑えたサーバ冷却を行うこととのバランスを考慮したためだと想像できる。サーバの密度を上げられるに越したことはない。しかし、密度を上げれば上げるほど、発生する熱への対策を積極的に行わなければならなくなる。強力な冷却を行おうとするほど、電力を消費する。従って、サーバ冷却のための電力消費を最小限に抑えることを出発点として考えると、最小の電力消費で対応できるレベルのサーバ密度しか実現できないことになる。

サーバの電力消費を抑える細かな工夫として、Open Compute Projectのマザーボード仕様では、使われていないPCI/PCI-eレーンを無効化できること、PCI-eスロットが使われない場合は無効にできること、USBポートも使われていないものは無効化できること、などがBIOSの要件として定められている。

マザーボード上には最前部と最背部、CPUに温度センサを設置、その数値に応じてファンの回転数を調節する機能が求められている。

電力効率には直接関係ないが、Open Compute ProjectではBIOSを入れ替えられるようにすることにこだわりを見せている。BIOSチップは基板にハンダ付けでなく、ソケットで装着するようにと指定されている。また、BIOSやBIOS設定をネットワーク経由で更新し、遠隔でハードウェアリブートができることを要件としている。

なお、このサーバはハードディスク用のドライブベイ(それぞれ2台のドライブを収容可能)を3つ設置できるようになっている。だが、そのうち2つはマザーボードと冷却ファンの間に設置するようになっていて、温度条件もメンテナンス性もあまりよくないことが考えられる。残りのドライブベイ1つは電源ユニットの後ろに置かれ、背面からドライブの抜き差しができる。

一方、サーバ電源ユニットの効率化は、電力利用の効率に直結する要因として、あらゆるサーバベンダが取り組んできた。フェイスブックがOpen Compute Projectで仕様を示したサーバ用電源ユニットは、Climate Savers Computing Initiative(IT利用の環境負荷低減を目指す非営利グループ、インテル、グーグルをはじめ約650の組織が参加)が定めたPLATINUMに準ずる効率を達成していることが要件となっている。具体的には、20%負荷で90%以上、50%負荷で94%以上、100%負荷で91%以上の効率だ。

この電源ユニットはバックアップバッテリユニットからの直流48Vも、入力できるようになっている。

バックアップバッテリユニットは、サーバキャビネット2つに対して1つの割合で、2つのサーバキャビネットに挟みこむようにして設置されるバッテリ装置。通常のように、大型の無停電電源装置(UPS)をインラインで接続することはしていない。インラインのUPSも、内部で交流を直流に変換し、さらに交流に戻すという動作をするならば、電力ロスの大きな原因となる。

また、一般的なUPSでは、負荷が低い状態のほうが電力損失は大きいことが知られている。このため、従来のようにデータセンター内に大型のUPSを配置し、しかも二重化しているような場合は、効率がかなり低下する。

Copyright © ITmedia, Inc. All Rights Reserved.