銀行がFinTech時代を勝ち抜くために行うデータ活用の事例とアーキテクチャ、テクノロジー:FinTech時代、銀行系システムはどうあるべきか(4)(3/3 ページ)

テクノロジーの適用例と、その価値

前述の通り、データ活用によって新たな洞察を得て現実にビジネスに生かしている事例が増えています。「データサイエンティストに限らず、マーケターや営業といったユーザー部門などの方々が、必要な時に、必要なときに、(社内・社外を問わず)必要なデータを使って、迅速に洞察を得る」ためのシステムアーキテクチャと、それを実現するプラットフォームやテクノロジーが求められています。こうしたプラットフォームに必要とされる要素を本節で述べます。

データレイク実現の主なコンポーネント概観

ニーズに応じて迅速にさまざまなデータを分析/活用するためのプラットフォームとして、「Data Lake(データレイク)」という考え方が、2010年に米国で提唱されました。データレイクを実現する主なコンポーネントのうち、図6に示す5つの領域について解説します。

なお、図4で示した銀行情報系アーキテクチャと図6に示すコンポーネントをマッピングすると、表2のようになります。

| 図6 データレイクのコンポーネント | 図4 銀行情報系アーキテクチャ | |

|---|---|---|

| 【1】セルフサービス | 〜 | データ利用層 |

| 【2】データカタログ | 〜 | データ利用層 |

| 【3】データ解析・処理 | 〜 | データ利用層 |

| 【4】データ連携・加工 | 〜 | データインタフェース |

| 【5】データリポジトリ | 〜 | データウェアハウス、ビッグデータ基盤、分析用データマート |

- セルフサービスとユーザーインタフェース(図6-【1】)

ユーザーが必要に応じてデータを入手し、ビジネスの目的に応じて自身でデータを分析、可視化するためのユーザーインタフェースです。セルフサービス機能を強化したBI(ビジネスインテリジェンス)ツールや分析ツールがこのコンポーネントで利用されます。

また1人のユーザーのセルフサービスを促進するだけではなく、チームでのコラボレーションを促進するために、以下の価値を提供することも重視されています。

- 【2】〜【5】の他のコンポーネントとシームレスに接続し、データの探索、収集、分析、デプロイまでを一気通貫で作業できること

- 上記作業を推進する上で、チームメンバー間での協業を促進するために、異なる言語での開発モジュールやデータセットを、統合されたプラットフォームで共有できること

これを実現するソリューションとして、Jupyter Notebook、GitHubといったオープンソースの技術が開発され、それらをエンタープライズ環境で活用するための拡張機能を追加したソリューションを、各ソフトウェアベンダーが提供を開始しています。

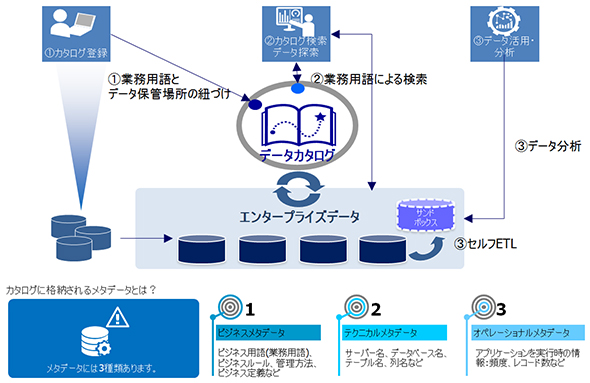

- データカタログ(図6-【2】)

ユーザー自身が必要なデータを探索し、取捨選択するために、データカタログを提供するコンポーネントです。このデータカタログには、メタデータを登録、蓄積、探索する機能が実装されます。

メタデータとは、データの定義情報であり、ビジネスユーザーが使えるようにするための用語(ビジネスメタデータ)、そのデータがどのソースから来ているかを示す情報(システムメタデータ)、アプリケーションやジョブの実行に関連する情報(オペレーショナルメタデータ)が含まれます。またビジネスメタデータとシステムメタデータのひも付け情報もデータカタログに登録されます。

このデータのカタログ化で、ユーザーがアクセス権のあるデータにセルフサービスでアクセス、入手できるため、データ活用までの期間が短縮されます。また、組織横断的にデータが可視化され、他部門のデータの利用が容易になるメリットもあります。

図7に利用イメージを示した通り、ユーザーはカタログを介してデータを探索し、探索したデータをセルフサービスETL(データの抽出、加工、ロードを担うソリューション)機能により、ユーザーが利用しやすいサンドボックスに抽出します。

- データ解析・処理(図6-【3】)

データから洞察を得るための分析エンジンが配置されるコンポーネントです。ここで利用される新しいテクノロジーとして、マシンラーニング(機械学習)とApache Spark(以下、Spark)を紹介します。

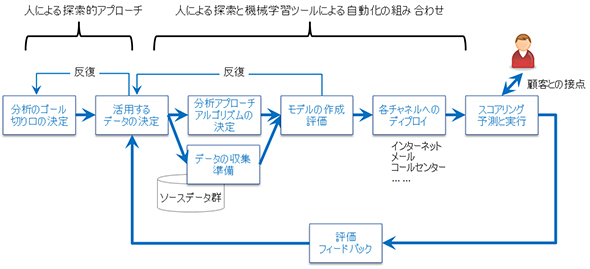

データ分析においては、「ビッグデータ活用に求められる銀行情報系アーキテクチャとは」の章で述べたビジネスゴールやユースケースに基づく、探索的なアプローチが重要であり、これらの反復作業が示唆や洞察の獲得には欠かせません。一方、市場では多数の分析モデルやアルゴリズムが開発されており、上記ビジネスゴールと入手できるデータセットから、最適なアルゴリズムを選択する必要があります。

これらをスピーディーに効率良く進めるために、機械学習を中心とした手法である程度自動化できるようになっています。機械学習では、多数の分析モデル/アルゴリズムとデータセットとを照合し、その中から最適なものを自動的に導出します。

人手による探索的なアプローチと、機械学習によるアルゴリズムの自動選択とを組み合わせることで、より最適な洞察を得るようにデザインすることが必要です。

図8に示すように、この連続線上で、作成したモデルの各チャネルへの展開、スコアリングの実行から評価に至るまで、ある程度自動的に行われるプラットフォームが必要とされています。

上記のアプローチを実行するプラットフォームを支えるエンジンとしてSparkを活用するケースが増えています。Sparkは、ビッグデータのキーテクノロジーとして、オープンソースのHadoopを補完する位置付けで注目されており、データ解析や計算処理を、分散されたサーバのインメモリで並列実行するソフトウェアです。

Sparkを銀行の情報系において活用する利点としては、下記が挙げられます。

- 大量データ処理の高速化

- 開発生産性の向上

- アルゴリズムの高度化

- 開発モジュールのプラットフォーム間の可搬性

大量データから高速に知見を得るために、生産性の高いプログラミング言語であるPython、R、Scalaなどで開発した機械学習のモジュールを、上記インメモリ処理の特性を生かせるSparkのプラットフォーム上で実行するような利用形態が考えられます。

- データ連携・加工(図6-【4】)

分析の下準備として、データを抽出し形を整え、他のデータとの整合性をとる作業が必須です。データ活用全体のプロセスの中で、このデータ準備に最も多くの時間が費やされているといわれています。また前述の機械学習エンジンによる分析の自動化を試みる場合にも、インプットするデータの前処理や加工が重要です。

このコンポーネントでは、ETL、レプリケーションや仮想化ソリューションが選択肢として挙がります。これらソリューションから、データ鮮度(リアルタイムまたはバッチ)、データ加工の複雑性、ユーザーのセルフサービスかシステム開発を許容するか、などの要件を加味して最適なソリューションを選択します。

このコンポーネントでは、データが流入する過程で瞬時に分析し洞察を得ることで、意思決定やアクションのスピードを高速化するためのテクノロジーとして、ストリームコンピューティングが使われるケースもあります。インターネットバンキングにログインした顧客の属性やセグメントから、取るべきアクションを機械学習モデルから瞬時に判断し、インターネット上でそのアクションを実行するようなケースでは、ストリームコンピューティングが活用されます。

- データリポジトリ(図6-【5】)

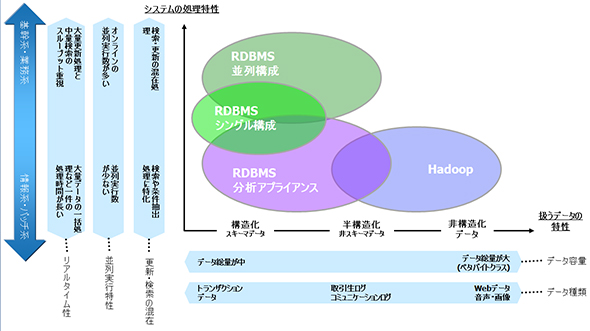

分析に活用するためのあらゆるデータを蓄積するコンポーネントです。各データリポジトリにアクセスする業務のデータ活用、蓄積に関する要件と、データリポジトリに適用される各テクノロジーの特性とのマッチングにより、最適なテクノロジーを選択します。例えば、従来リポジトリとして使用されているリレーショナルデータベースと、昨今の活用が進んでいるHadoopの特性の違いを概観すると図9の通りです。

図4で示したアーキテクチャのビッグデータ基盤での処理に代表されるように、大量な非構造データを構造化し扱うための前処理、あるいは非構造データから洞察を得るための分析処理のために、Hadoopが使われるケースがあります。処理の一例としては、ソーシャルメディアに投稿されたメッセージなど大量なテキストの中から、関連する文脈や単語を探し出す処理が挙げられます。このケースでは、テキストデータの蓄積とテキストマイニングを行うプログラムの実行環境として、Hadoopが利用されます。

前述したSparkは、Hadoop上の処理性能を上げたり、開発者の生産性を上げたりする目的で開発されました。従って、Sparkとの親和性が高いPythonやRといったプログラミング言語で、Hadoop上のデータを扱うアプリケーションが開発されることが多くなっています。またSQL on Hadoopのテクノロジーもあり、SQLに慣れた人がHadoop上のデータを扱えるようになっています。

なお、こうしたプラットフォームの技術要素は従来型のBIやデータウェアハウスを置き換えるものではなく、それを補完するものです。また、単一のプロジェクトとして集約型のプラットフォーム上に実現するものではなく、既存の拡張として取捨選択し実装するものです。従ってスモールスタートによる既存システムの拡張を可能としています。例えば、データカタログとサンドボックスのみ従来の環境に追加し、ユーザーが利用しやすい基盤を整備するといったアプローチが可能です。

コグニティブ技術の適用について

さらに昨今のコグニティブやAI技術によりデータ活用の高度化が促進されるでしょう。例えば、以下のような目的で、すでにソリューションが実装されていたり、開発が進んでいたりします。

- 経営者や営業担当者らが自分自身でデータの可視化やダッシュボードの生成をする支援のために、コグニティブ技術が活用される(図6-【1】セルフサービス)

- 見たい情報を自然言語で入力することで、データを探索し、データの型式に応じた可視化を自動的に行う

- ビジネス担当者が自然言語でのデータ探索を実現するために、システムに登録されているメタデータから、そのデータが持つビジネス上の意味に読み替えるのに、コグニティブ技術が活用される(図6-【2】データカタログ)

- データ分析自動化の促進のために、得られるデータから適切な洞察を得るためのアルゴリズムの自動選択に、コグニティブ技術が活用される(図6-【3】データ解析)

このように、企業ビジネスへのデータ活用の方針を考案し、適切なアプローチとアーキテクチャを判断する方たちの作業を補完する位置付けで、コグニティブ/AI技術が活用され始めています。

まとめ

FinTech時代の今、データ活用を進めるに当たり、「長期的な計画を立てつつ、少しずつ取り組み、素早く展開する」ことが重要となります。データドリブンのビジネス貢献に必要な人材やプロセス、テクノロジーに対して長期的なビジョンを持ちつつ、「業務や部門単位などで小さく始めて、その成果を実証していく」ことが重要視されていると考えます。

また、その短期的な実証の成果に対する可能性が周囲のステークホルダーに認知されるよう可視化しながら、大きく育てていくことが必要になります。本稿に記載したビジネス、データ、アーキテクチャ、テクノロジーを上流から下流まで総合的にデザインする組織、人材の育成が求められるでしょう。

次回は、FinTechで活用検討が進むブロックチェーンについて

今回は、顧客インサイトを深めるためのデータ分析アーキテクチャおよびテクノロジーについてご紹介しました。顧客が主導権を握るFinTech時代にデータ分析をどう活用していけばよいのか、そのための要素技術とその進化や方向性について説明しました。

次回は、FinTech領域で活発に検討が進んでいるブロックチェーンを紹介します。

デジタルビジネス全盛時代、ITサービス競争に勝つ“インフラ”の最適解 〜SoEとSoRの両輪でデジタル変革は加速する〜

昨今、ITサービスのように変化対応力が重要な領域をSoE(Systems of Engagement)、基幹システムのように安定性が重要な領域をSoR(Systems of Record)と分けて扱う考え方が浸透してきたが、“価値あるサービス”を提供し続けるためには、SoE、SoRがそれぞれ単独で機能を果たすのではなく、耐えず連動しながらイノベーションを生み出すことが求められる。その実現に向けては、アプリケーションの開発と同時に、そのパフォーマンスを支える“ITインフラの在り方”が肝となり、ITサービス競争を勝ち抜く切り札となるのだ。では具体的に、両領域をどのように連携・改善させればいいのか――本テーマサイトでは、先進事例や動向とともに、全業種に通じる“デジタル変革の確実な進め方”を紹介する。

関連記事

みずほ銀行が日立のプライベートクラウド採用、次期勘定系システムに

みずほ銀行が日立のプライベートクラウド採用、次期勘定系システムに

日立製作所の従量課金型プライベートクラウドサービスが、みずほ銀行の次期勘定系システムと、2016年度に稼働予定の総給振システムに採用された。 FinTech時代の到来で日本の金融システムはどう変わるのか?――銀行グループ改革と金融規制の在り方を問う

FinTech時代の到来で日本の金融システムはどう変わるのか?――銀行グループ改革と金融規制の在り方を問う

金融とITの融合によって多様で革新的な金融サービスを生み出す原動力になると期待されるFinTech。FinTechは日本の金融システムに何をもたらそうとしているのか? 1月20日に開催された「BINET倶楽部セミナー」では、日本総合研究所の副理事長で金融審議会の臨時委員を務める翁百合氏が「FinTechの現状と日本の金融システム」と題して講演を行った。 金融庁はFinTech革命にどう向き合うのか?――新たな決済サービス、キャッシュマネジメントサービス、電子記録債権、XML電文、国際ローバリュー送金、そして規制改正

金融庁はFinTech革命にどう向き合うのか?――新たな決済サービス、キャッシュマネジメントサービス、電子記録債権、XML電文、国際ローバリュー送金、そして規制改正

金融とITの融合によって多様で革新的な金融サービスを生み出す原動力になると期待されるFinTech。FinTechは日本の金融システムに何をもたらそうとしているのか? 1月20日に開催された「BINET倶楽部セミナー」では、金融庁総務企画局企画課で企画官を務める神田潤一氏が「日本におけるFinTechの活性化に向けた金融庁の取り組み」と題して講演を行った。

Copyright © ITmedia, Inc. All Rights Reserved.