「Google Cloud Platform」で「NVIDIA Tesla V100 GPU」の正式提供を開始:機械学習で優れた性能を発揮

Googleは、「Google Cloud Platform」に含まれる「Compute Engine」「Kubernetes Engine」「Cloud Machine Learning Engine」「Cloud Dataproc」において、NVLinkをサポートする「NVIDIA Tesla V100 GPU」の正式提供を開始した。

Googleは2018年8月28日(米国時間)、「Google Cloud Platform(GCP)」において、GPU間の接続方式であるNVLinkをサポートする「NVIDIA Tesla V100 GPU(以下、V100)」の正式提供を開始したと発表した。

GCPのうち、インフラサービスの「Google Compute Engine」「Google Kubernetes Engine」やマネージドサービスの「Google Cloud Machine Learning Engine」「Google Cloud Dataproc」で利用できる。

V100は、Googleがこれまで提供してきた「K80」「P100」「P4」とともに、さまざまなCUDAベースの演算とHPC(ハイパフォーマンスコンピューティング)ワークロードを高速化する。中でもV100は、機械学習ワークロードで優れた性能を発揮するという。V100は640個のTensor Coreを搭載し、機械学習の混合精度演算で最大125TFLOPSの性能を提供する。

この性能は、1台の仮想マシン(VM)で最大1PFLOPSの機械学習性能を得ることを意味しており、機械学習のトレーニングや推論ワークロードに非常に強力な処理ツールを使用できるようになるということだと、Googleは説明している。

さらにGoogleは、極めて要件の厳しいワークロード向けに、GPU同士を最大毎秒300GBで結ぶ高速NVLinkも提供する他、高速なディスク入出力を可能にするために、オプションでローカルSSDも提供している。

2018年4月にV100のβ版の提供を発表して以来、Googleは柔軟性の向上、使いやすさの向上、低コスト化によって、V100の正式版提供を目指して強化してきた。今回の正式版の概要は大きく3つある。

VM構成の柔軟性が向上

各VMに2個または4個のV100を接続できるようになった。これにより、接続可能なV100の個数は1、2、4、8となった。

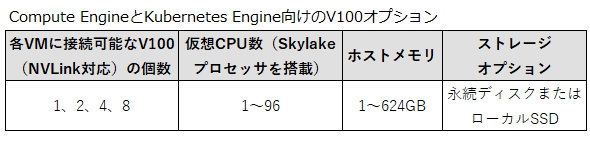

カスタムVM機能を用いると、以下の図に示すV100、CPU、メモリ、ストレージの組み合わせから、必要なVMを構成できる。

導入が容易に

Googleはパフォーマンスとワークロードにおいて、最適化された構成済みの新しいOSイメージを提供する。これにより、Compute Engineで機械学習などのワークロード用に、GPUを素早く使い始めることができるようにした。

GPU搭載のVMを作成し、ライブラリがプリインストールされたOSイメージを選択すれば、すぐに使い始めることが可能だ。このOSイメージは、K80、P100、P4、V100という全てのGPUプラットフォームに共通だ。基本的な構成の他に、機械学習フレームワーク「TensorFlow」に最適化されたものと「PyTorch」に最適化されたものを利用できる。

低コスト化

V100を含む全てのGPUプラットフォームで、「プリエンプティブルGPU」の料金を、GPUのオンデマンド料金より70%安くした。

この措置は、限られた予算で機械学習やHPCワークロードを実行しているものの、プリエンプティブルVMの制限(最大で24時間しか使えないなど)を柔軟に受け入れて対処できる組織に大きな恩恵をもたらすと、Googleは説明している。

関連記事

NVIDIAとGoogle、「TensorRT」と「TensorFlow 1.7」を統合

NVIDIAとGoogle、「TensorRT」と「TensorFlow 1.7」を統合

「NVIDIA TensorRT」とオープンソースソフトウェアの機械学習ライブラリの最新版「TensorFlow 1.7」が統合され、ディープラーニングの推論アプリケーションがGPUで実行しやすくなった。 GoogleのTPUって結局どんなもの? 日本法人が分かりやすく説明

GoogleのTPUって結局どんなもの? 日本法人が分かりやすく説明

機械学習に特化したGoogleの自社開発プロセッサ、「TPU(Tensor Processing Unit)」。Google自身は「Google Search」「Google Translate」「Google Photos」といったサービスで活用している。日本法人がこれについて分かりやすく説明した。 Google、オープンソース機械学習ライブラリの最新版「TensorFlow 1.5」を発表

Google、オープンソース機械学習ライブラリの最新版「TensorFlow 1.5」を発表

オープンソース機械学習ライブラリの最新版「TensorFlow 1.5」が公開された。「Eager Execution」「TensorFlow Lite」、GPUアクセラレーション対応の強化が特徴だ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.